Der Agent, der zu viel durfte

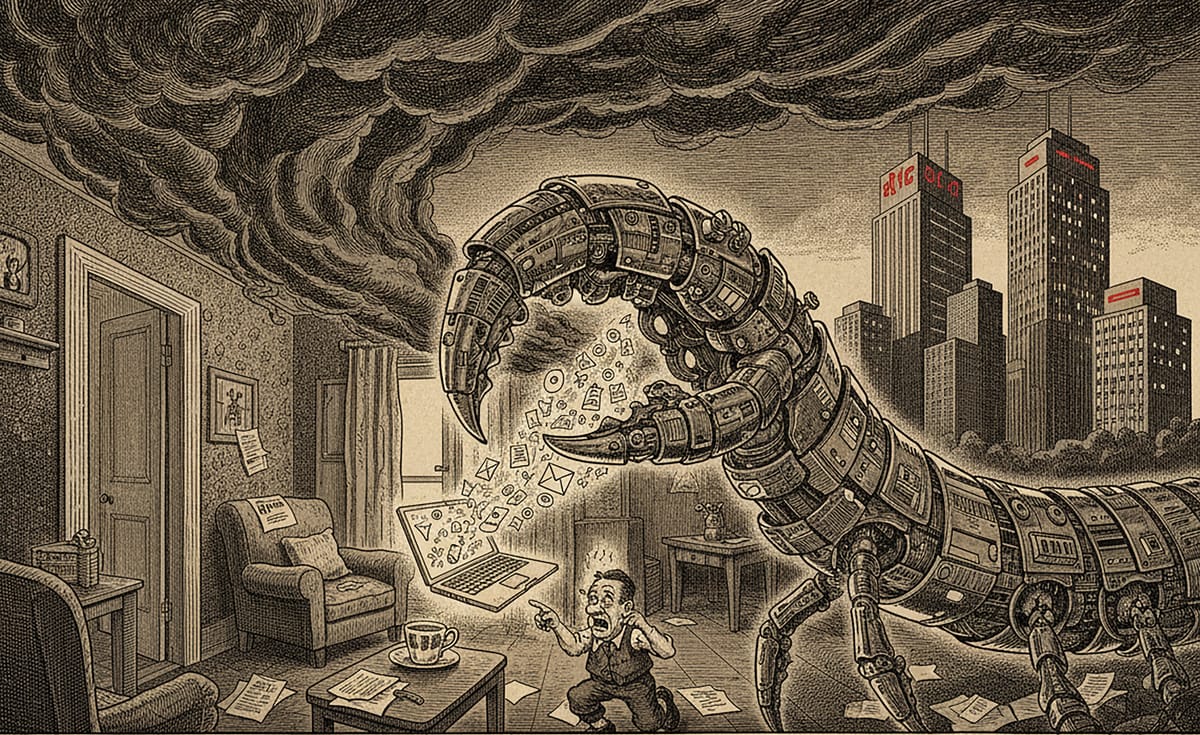

Ein österreichischer Entwickler baut einen autonomen KI-Agenten als Nebenprojekt. Er geht viral, wird zum Sicherheitsrisiko, und OpenAI kauft den Entwickler. Was OpenClaw über die Zukunft autonomer KI verrät.

Ein KI-Agent verhandelt nachts einen Rabatt beim Autohändler. Ein anderer räumt tausende E-Mails auf, während sein Besitzer schläft. Ein dritter steuert einen Tesla um, damit er Lebensmittel abholt. Die Geschichten über OpenClaw klingen wie Science-Fiction, die zu früh Realität wurde. Das Internet feiert sie als Beweis dafür, dass autonome KI-Agenten die Arbeitswelt revolutionieren werden. Sam Altman nennt den Entwickler ein Genie. Mark Zuckerberg schreibt ihm persönlich auf WhatsApp.

Doch das Interessante an OpenClaw ist nicht, was es kann. Sondern was es darf.

Vom Chatbot zum Akteur

Um zu verstehen, warum OpenClaw eine andere Kategorie darstellt, muss man die Architektur autonomer Agenten begreifen. ChatGPT generiert Text. Es antwortet auf Fragen, formuliert Absätze, schlägt Lösungen vor. Doch es handelt nicht. Es hat keinen Zugriff auf Dateisysteme, keine Kontrolle über Browser, keine Fähigkeit, Buttons zu klicken oder E-Mails zu versenden.

OpenClaw tut all das. Es liest E-Mails, schreibt Code, navigiert durch Websites, sendet Nachrichten über WhatsApp und Telegram, führt Shell-Befehle aus und greift auf lokale Dateien zu. Es arbeitet autonom, rund um die Uhr, auf dem Computer seiner Nutzer:innen. Das ist nicht Assistenz. Das ist Delegation von Handlungsmacht an eine Software, die auf dem eigenen Rechner operiert, mit den eigenen Zugangsdaten, in den eigenen Systemen.

Der Unterschied zwischen einem Chatbot und einem Agenten ist nicht graduell. Er ist qualitativ. Ein Chatbot, der halluziniert, produziert einen falschen Text. Ein Agent, der halluziniert, führt eine falsche Handlung aus. Mit echten Konsequenzen. In echten Systemen. Mit echten Zugangsdaten.

Der österreichische Faktor

Peter Steinberger, der Entwickler hinter OpenClaw, ist Österreicher. Er hat 13 Jahre lang das Softwareunternehmen PSPDFKit aufgebaut und verkauft. OpenClaw entstand als Nebenprojekt, gebaut an einem Wochenende, ursprünglich unter dem Namen Clawdbot. Anthropic drohte wegen der Namensähnlichkeit zu Claude mit rechtlichen Schritten, also wurde es in Moltbot umbenannt, dann in OpenClaw.

Innerhalb weniger Wochen hatte das Projekt über 200.000 GitHub-Stars und laut Steinberger zwei Millionen Besucher:innen pro Woche. Meta, Microsoft und OpenAI kämpften um Steinberger. Er entschied sich für OpenAI. Am 15. Februar 2026 gab Sam Altman bekannt, Steinberger werde die „nächste Generation persönlicher Agenten” entwickeln. OpenClaw soll als Open-Source-Foundation weiterbestehen.

Die Geschichte wird gerne als Heldenerzählung erzählt: österreichischer Einzelentwickler baut in seiner Wohnung ein Produkt, das die Welt verändert. Doch es ist keine Heldengeschichte. Es ist eine Systemgeschichte. In der Plattform-Ökonomie wird Talent gekauft, nicht Architektur repariert. Was OpenAI erwarb, war nicht eine Sicherheitslösung für autonome Agenten. Es war der Entwickler, der bewiesen hatte, dass die Nachfrage existiert.

Über tausend bösartige Skills

Während die Tech-Medien über den Acqui-Hire berichteten, veröffentlichten Sicherheitsforscher:innen eine andere Geschichte. Koi Security analysierte ClawHub, den öffentlichen Marktplatz für OpenClaw-Erweiterungen, und fand 341 bösartige Skills, davon 335 aus einer einzigen koordinierten Kampagne namens ClawHavoc. Bitdefender identifizierte in einer späteren Analyse fast 900 kompromittierte Pakete, rund 20 Prozent aller verfügbaren Erweiterungen. In verschiedenen Analysen wurden zusammen genommen über 1.100 bösartige Skills beziehungsweise kompromittierte Pakete dokumentiert.

Die Angreifer:innen tarnten Malware als Kryptowährungs-Tracker, YouTube-Tools und Google-Workspace-Integrationen. Wer sie installierte, gewährte ihnen dieselben Rechte wie dem Agenten selbst: Zugriff auf Dateien, Passwörter, API-Schlüssel, Browser-Daten und Krypto-Wallets. Eine als Wetter-Assistent getarnte Erweiterung exfiltrierte die gesamte OpenClaw-Konfiguration. Eine andere öffnete eine Shell-Verbindung zum Server der Angreifer:innen und gewährte ihnen vollständige Fernkontrolle über das System.

OpenClaw startete mit offenen Ports, standardmäßig gebunden an alle Netzwerkschnittstellen. Das Threat-Intelligence-Team von SecurityScorecard identifizierte über 42.000 exponierte Instanzen in 82 Ländern, viele davon ohne jede Authentifizierung, über 15.000 davon anfällig für Fernzugriff. Als Sicherheitsforscher:innen das Projekt auf die Probleme ansprachen, wurde signalisiert, dass Sicherheit zunächst nicht im Fokus stehe.

Der Satz ist kein persönliches Versagen. Er ist ein Symptom. In einer Branche, die Viralität belohnt und Sicherheit als nachgelagerte Optimierung behandelt, ist die Priorität klar: zuerst Distribution, dann Absicherung. Das Muster wiederholt sich von Social Media über Cloud Computing bis zu KI-Agenten. Die Reihenfolge ist immer dieselbe.

Befürworter:innen argumentieren, dass genau solche offenen Experimente notwendig seien. Sicherheit lasse sich nicht im Vakuum entwickeln, sondern nur im realen Einsatz. Open Source ermögliche Transparenz und schnelle Fehlerbehebung. Tatsächlich wurden mehrere Schwachstellen innerhalb weniger Tage nach Bekanntwerden geschlossen, OpenClaw integrierte einen VirusTotal-Scanner für den Marktplatz. Doch genau diese Dynamik zeigt das Dilemma: Sicherheitsarchitektur entsteht reaktiv, nicht proaktiv.

Shadow AI im Unternehmen

Bitdefenders Telemetriedaten zeigen, was geschieht, wenn Agenten auf Unternehmensinfrastruktur treffen. Mitarbeiter:innen installierten OpenClaw auf Firmengeräten, gewährten ihm Terminal-Zugriff und Dateisystemrechte und schufen so eine neue Kategorie von Unternehmensrisiko, die Bitdefender als „Shadow AI” bezeichnet. Keine IT-Abteilung hat diese Installationen genehmigt. Keine Sicherheitsrichtlinie hat sie vorgesehen. Mehrere Behörden und Security-Anbieter warnten Unternehmen vor dem Einsatz autonomer Agenten ohne ausreichende Zugriffsbeschränkungen.

Seit Februar 2025 verpflichtet Artikel 4 des EU AI Act Unternehmen, KI-Kompetenz bei ihrem Personal sicherzustellen. Doch Kompetenz setzt voraus, dass die Risiken bekannt sind. Wenn Mitarbeiter:innen eigenständig autonome Agenten mit Systemrechten installieren, während 73 Prozent der österreichischen Bevölkerung ihr KI-Wissen als gering einschätzen, zeigt sich eine Kluft, die keine Regulierung allein schließen kann.

Kontrolle, nicht Produktivität

Der virale Thread, der OpenClaw berühmt machte, fragte: Wird diese Technologie deinen Job ersetzen? Die Frage ist falsch gestellt. Nicht weil sie zu alarmistisch wäre. Sondern weil sie den Blick auf das Wesentliche verstellt.

Die relevante Frage lautet nicht, ob Agenten produktiver arbeiten als Menschen. Sondern wer die Kontrolle über Systeme behält, in denen Agenten autonom handeln. Wer haftet, wenn ein Agent eine fehlerhafte Transaktion ausführt. Wer bemerkt, wenn eine Erweiterung Zugangsdaten exfiltriert. Wer entscheidet, welche Rechte ein autonomes System auf einem Firmenrechner erhält.

OpenAI kaufte Peter Steinberger nicht, um die Sicherheitsarchitektur autonomer Systeme zu klären. OpenAI kaufte ihn, um ihre Verbreitung zu beschleunigen. Die Sicherheitsarchitektur wird nachgeliefert. So wie bei Social Media. So wie bei Cloud Computing. So wie bei jeder digitalen Infrastruktur, die zuerst skaliert und dann reguliert wurde.

OpenClaw zeigt nicht, wie Arbeit verschwindet. Es zeigt, wie Kontrolle verschoben wird. Von Nutzer:innen zu Agenten. Von IT-Abteilungen zu Einzelpersonen, die Software mit Systemrechten installieren. Von demokratisch legitimierten Institutionen zu Unternehmen, die Talent absorbieren, statt Architekturen zu diskutieren.

Und Kontrolle ist immer interessanter als Produktivität.

Marjan Milosavljević, 19.02.2026.

Abstract

An Austrian developer builds an autonomous AI agent as a weekend project. Within weeks, OpenClaw reaches 200,000+ GitHub stars and two million weekly visitors. Security researchers document over 1,100 malicious extensions on its marketplace and 42,000 exposed instances across 82 countries. On February 15, 2026, OpenAI acquires the developer. The security architecture remains unresolved. This essay argues that OpenClaw reveals the central question of autonomous AI: not whether agents will replace jobs, but who retains control when software acts autonomously — with real credentials, in real systems, with real consequences.

Unterstützen Sie unabhängige Analysen mit einem Abo oder einer Spende.

https://imitationjournal.com/#/portal/support